Để SEO website lên TOP cần có rất nhiều yếu tố kỹ thuật, con người, tài chính… tuy nhiên việc thấu hiểu cơ chế tìm kiếm của google là điều thực sự cần thiết cho bất kỳ bạn nào muốn tìm hiểu về SEO. Chúng ta phải hiểu Google hoạt động như thế nào? Tại làm sao Google lại có thể trả về kết quả khi ta search một keyword nào đó? Và đặt ra câu hỏi trong số những thuật toán loằng ngoằng của Google đưa ra chắc hẳn sẽ phải có những bảo mật nhất định.. vậy ta có thể can thiệp ( tác động ) như thế nào để Google ” để mắt ” tới website của chúng ta nhiều hơn? Làm sao để nó ” nâng đỡ” cho mình lên TOP1 mà không phải là đối thủ?

Công cụ tìm kiếm của google hoạt động thế nào?

1. Các bộ phận của Google.

– Thu thập dữ liệu ( Spider).

– Phân tích dữ liệu – lập chỉ mục.

– Mã hóa – thuật toán.

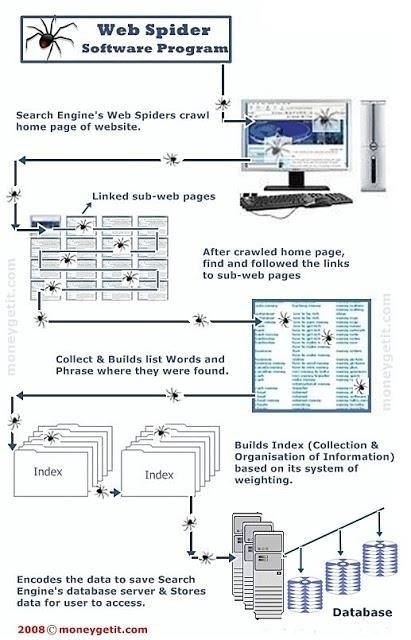

2. Spider ( con bọ tìm kiếm của Google) Crawling & Indexing như thế nào?

Spider có thể:

– Crawling qua link trên các site đã index theo chỉ định của Meta name.

– Crawling qua Ip server reversed, DNS

– Crawling qua full domain search

Cơ chế tìm kiếm của spider:

Chúng ta theo dõi qua sơ đồ này để hiểu hơn.

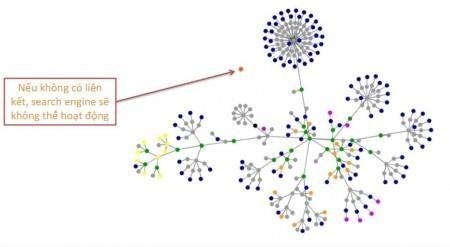

– Đầu tiên nó lấy danh sách các máy chủ và trang web phổ biến. Spider sẽ bắt đầu tìm kiếm với một site nào đó, nó đánh chỉ mục các từ trên trang của nó và theo các liên kết ( link) tìm thấy bên trong Site này. Theo phương pháp này, hệ thống tìm kiếm của Google sẽ nhanh chóng thực hiện công việc và trải rộng ra toàn bộ các phần được sử dụng rộng rãi nhất của web.

– Khi Spider xem xét các trang web ( định dạng HTML), nó lưu ý: Các từ bên trong trang web & Nơi nó tìm thấy các từ đó

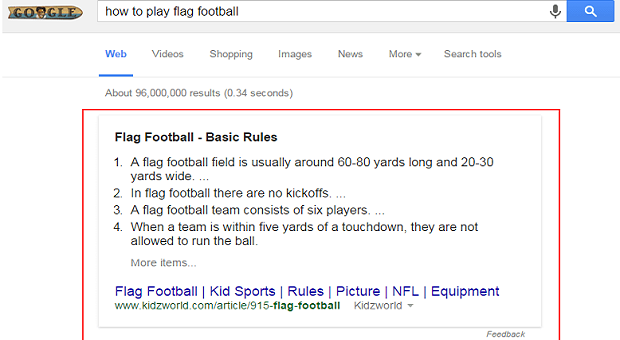

Các từ xuất hiện trong các thẻ Title, Meta Description…. nó nhận định đó là phần quan trọng có liên quan đến sự tìm kiếm của người dùng sau này. Vì thế đối với mỗi website google nó sẽ có nhiều phương pháp để index lại chỉ mục, liệt kê lại các từ khóa chính. Nhưng dù dùng cách nào thì Google cũng luôn cố gắng làm cho hệ thống tìm kiếm diễn ra nhanh hơn để người dùng có thể tìm kiếm hiệu quả hơn hoặc cả hai.

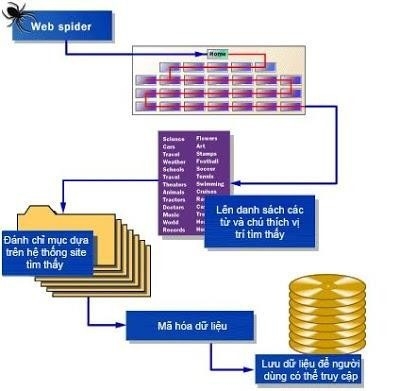

– Kế đó Google sẽ xây dựng chỉ mục.

Sau khi nó tìm thông tin trên website nó sẽ nhận ra rằng nhiệm vụ tìm kếm thông tin trên website sẽ không thể nào hoàn thành… bởi vì các QTV luôn thay đổi thông tin, cập nhật thông tin lên website và điều đó có nghĩa rằng Spider sẽ luôn thực hiện nhiệm vụ Crawling. Và chắc chắn rằng Google sẽ phải lưu các thông tin mà nó tìm được bằng một cách nào đó để có lợi nhất.

– Sau đó nó sẽ mã hóa thông tin để lưu trữ dữ liệu trong CSDL đồ sộ của nó theo một thuật toán nào đó… chắc chắn là rất bảo mật rồi.

– Rồi nó xây dựng chỉ mục để cho phép thông tin được tìm thấy một cách nhanh chóng. Chúng có thể lấy ví dụ 1 cách như sau: Giả sử website của bạn làm về ngành du lịch… nó sẽ lưu các chỉ mục của website của bạn vào phần du lịch… Nếu site bạn làm về ca nhạc, nó sẽ lưu các chỉ mục web bạn vào phần ca nhạc… và như thế sẽ tránh được việc tìm kiếm bị chồng chéo lên nhau… vì ắt hẳn ai cũng biết rằng bộ máy tìm kiếm google có dữ liệu lớn tới mức nào.

Tóm lại chúng ta chỉ có thể can thiệp vào quy trình tìm kiếm của Google ở bước nó bắt đầu tìm kiếm và lên chỉ mục website. Còn về thuật toán cũng như hệ thống của Google thì thật khó để có thể can thiệp vào. Và cũng từ đây sản sinh ra 2 trường phái SEO: BlackHat SEO và WhiteHat SEO.